- 전체

- Python 일반

- Python 수학

- Python 그래픽

- Python 자료구조

- Python 인공지능

- Python 인터넷

- Python SAGE

- wxPython

- TkInter

- iPython

- wxPython

- pyQT

- Jython

- django

- flask

- blender python scripting

- python for minecraft

- Python 데이터 분석

- Python RPA

- cython

- PyCharm

- pySide

- kivy (python)

Python 일반 [python] Apache Airflow 소개 및 실습하기(기초)

2022.07.25 22:23

[python] Apache Airflow 소개 및 실습하기(기초)

Apache Airflow는 배치 스케쥴링(파이프라인) 플랫폼입니다

실행할 Task(Operator)를 정의하고 순서에 등록 & 실행 & 모니터링할 수 있습니다

DAG(Directed Acyclic Graph, 비순환 방향 그래프)로 각 배치 스케쥴이 관리됩니다

DAG하위에는 고유한 여러 Task가 존재하며 순서를 갖습니다

Task는 BashOperator, PythonOperator 등 다양한 Operator를 지원합니다

[배치 스케쥴링할 때 고려해야 할 문제들]

일부 Task가 실패했습니다. 어떻게게 인지하고 재실행할 수 있을까요?

각 Task는 선행조건과 수행시간이 다릅니다. 어떤 순서가 최적일까요?

수행시간이 일부 Task는 짧고 일부 Taks는 깁니다. 어떤 이유일까요? 로그는 쉽게 찾아 비교할 수 있을까요?

여러 서버에 Task가 존재합니다. 어떻게 스케쥴링 할 수 있을까요?

과거 일부 Task가 실행이 누락되었습니다. 과거기준으로 다시 실행할 수 있을까요?

Airflow는 이 문제에 해답을 제시합니다

그럼 실습환경을 구축하고 실습코드를 만들어 스케쥴링해보겠습니다

1) 도커 이미지를 가져옵니다

2) 도커 컨테이너를 실행합니다

3) conda를 이용하여 필요한 모듈을 설치합니다

4) cfg(환경설정파일)과 기본데이터베이스(SQLite)를 초기화합니다 (SQLite이외 다른 DB 사용 가능)

5) 사용자 환경변수에 airflow 경로를 추가하고 활성화합니다

6) DAG(Directed Acyclic Graph, 비순환 방향 그래프)파일을 저장할 디렉토리를 만듭니다

기본 폴더 구조는 아래와 같습니다

airflow.cfg파일에 dags, logs폴더가 지정되어 있습니다.

dags_folder = /home/jovyan/airflow/dags

base_log_folder = /home/jobyan/airflow/logs

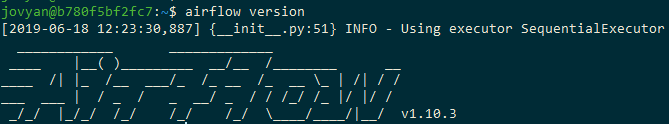

7) 설치된 airflow 버전을 확인합니다

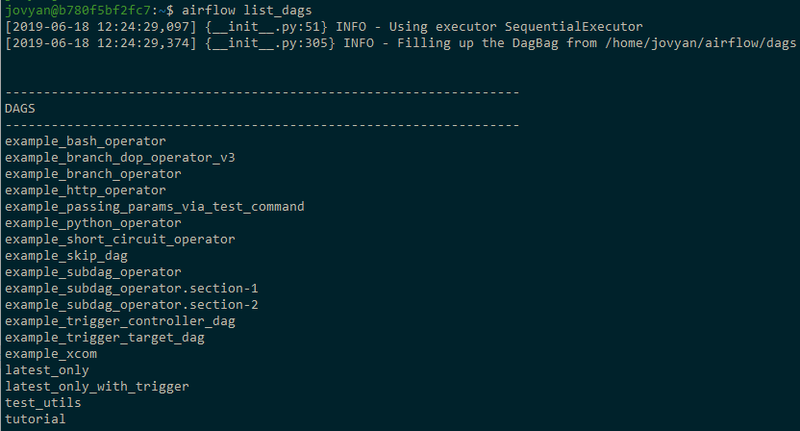

8) 등록된 DAG 목록을 조회합니다

9) dags 폴더에 실습할 my_first.py 을 만듭니다

[소스코드]

10) 코드를 실행해봅니다(문법 오류 정도를 검증할 수 있습니다)

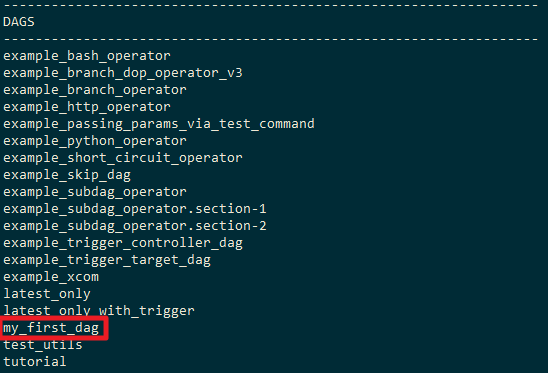

11) 다시 등록된 DAG 목록을 조회합니다

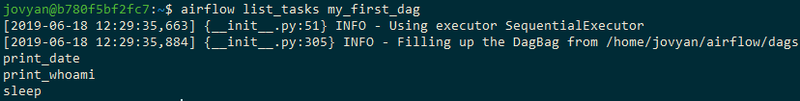

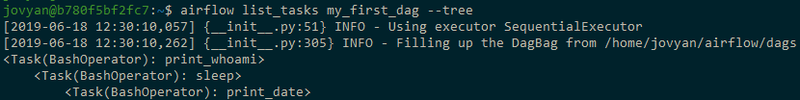

12) 새로만든 DAG의 Task를 조회합니다

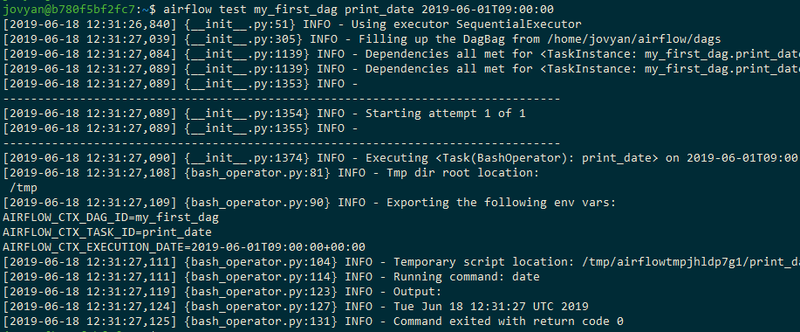

13) 테스트로 Task 1개만 실행해봅니다

14) airflow 스케쥴러를 실행합니다

15) 스케쥴러를 컨트롤하고 관리할 웹서버를 실행합니다

16) 웹브라우저로 접속합니다

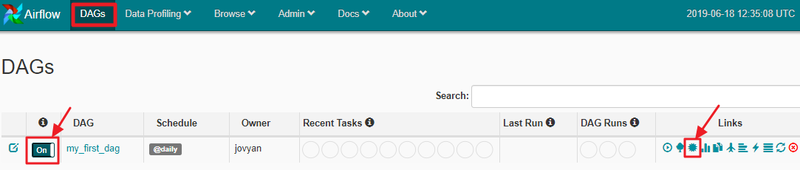

17) DAGs 탭에서 만들었던 my_first_dag을 Off에서 On으로 활성화 합니다

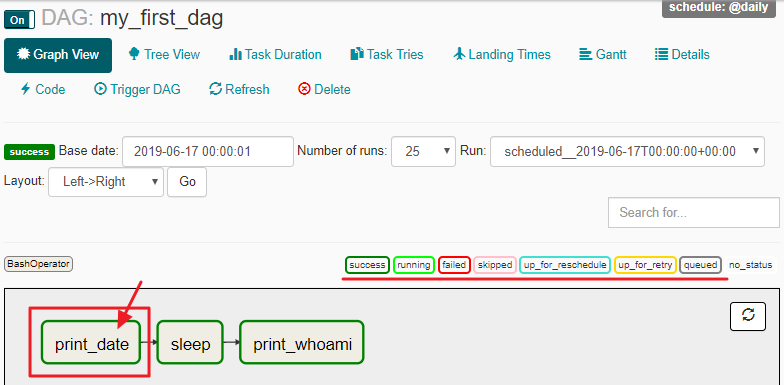

18) Graph View를 통해 각 Operator의 순서와 상태를 확인할 수 있습니다

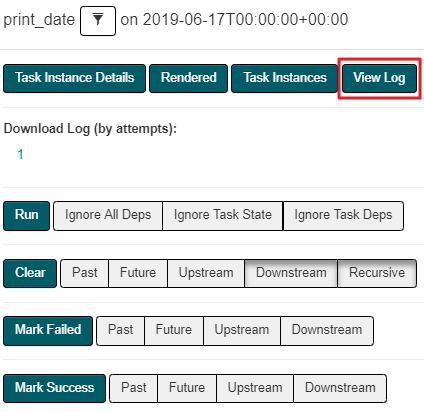

19) Operator 팝업에서 "View Log"를 클릭합니다

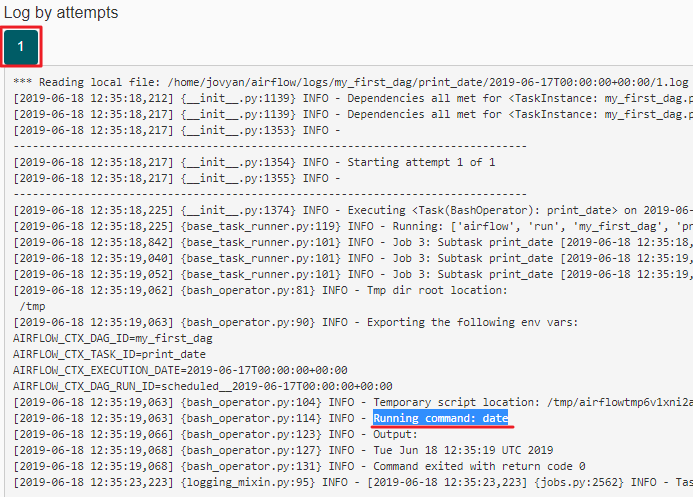

20) 해당 Operator의 실행 차수별 로그를 확인할 수 있습니다

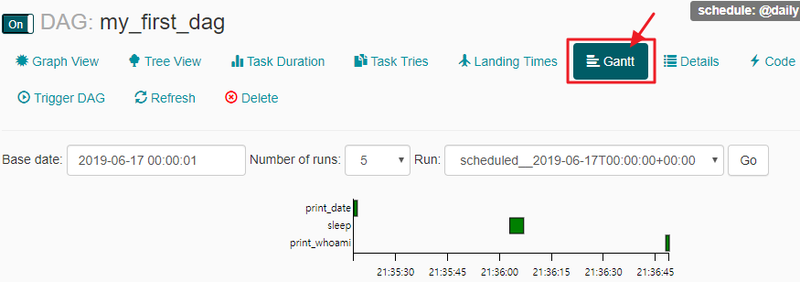

21) Gantt 차트를 확인해보겠습니다

Airflow는 다양한 종류의 Operator를 지원합니다.

위 기초 실습에서는 이해를 돕기 위해 BashOperator 만을 사용했습니다.

끝.

[출처] https://m.blog.naver.com/wideeyed/221565240108

광고 클릭에서 발생하는 수익금은 모두 웹사이트 서버의 유지 및 관리, 그리고 기술 콘텐츠 향상을 위해 쓰여집니다.

댓글 0

| 번호 | 제목 | 글쓴이 | 날짜 | 조회 수 |

|---|---|---|---|---|

| 3 |

[python RPA] Robotic Process Automation with Python

| 졸리운_곰 | 2022.03.03 | 157 |

| 2 |

[python RPA] 3 WAYS TO DO RPA WITH PYTHON

| 졸리운_곰 | 2022.03.03 | 107 |

| 1 | [Python RPA] [Python] - 모듈탐구 pyautogui - Python 폴터가이스트 | 졸리운_곰 | 2022.03.03 | 89 |